FÜR 0 Euro!

Deine Anmeldung konnte nicht gespeichert werden. Bitte versuche es erneut.

Deine Anmeldung war erfolgreich.

Webdesign abgestimmt auf die Unternehmensphase

Ich arbeite mit Methode

Strategisch – Betriebswirtschaftlich – Automatisiert – Wachstumsorientiert

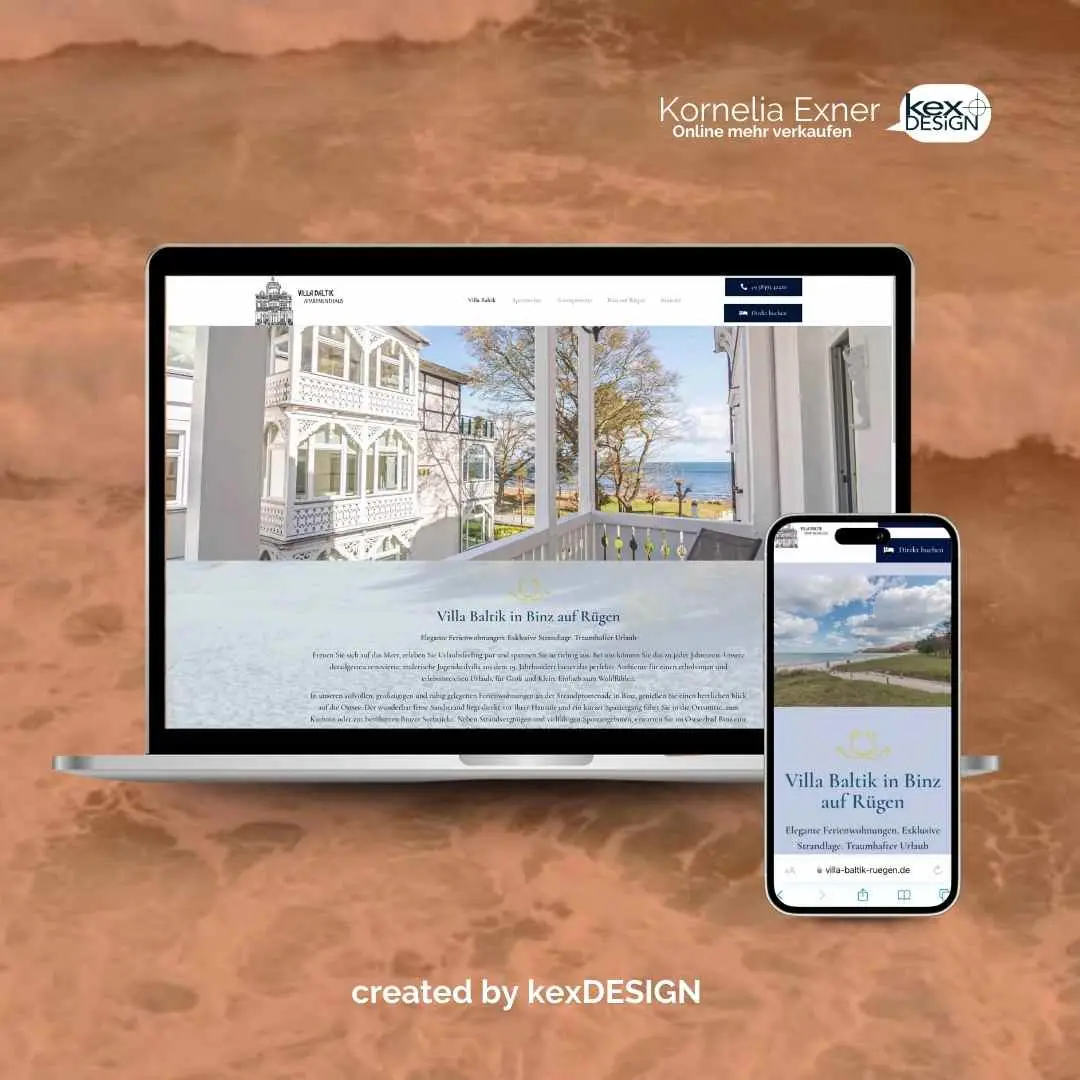

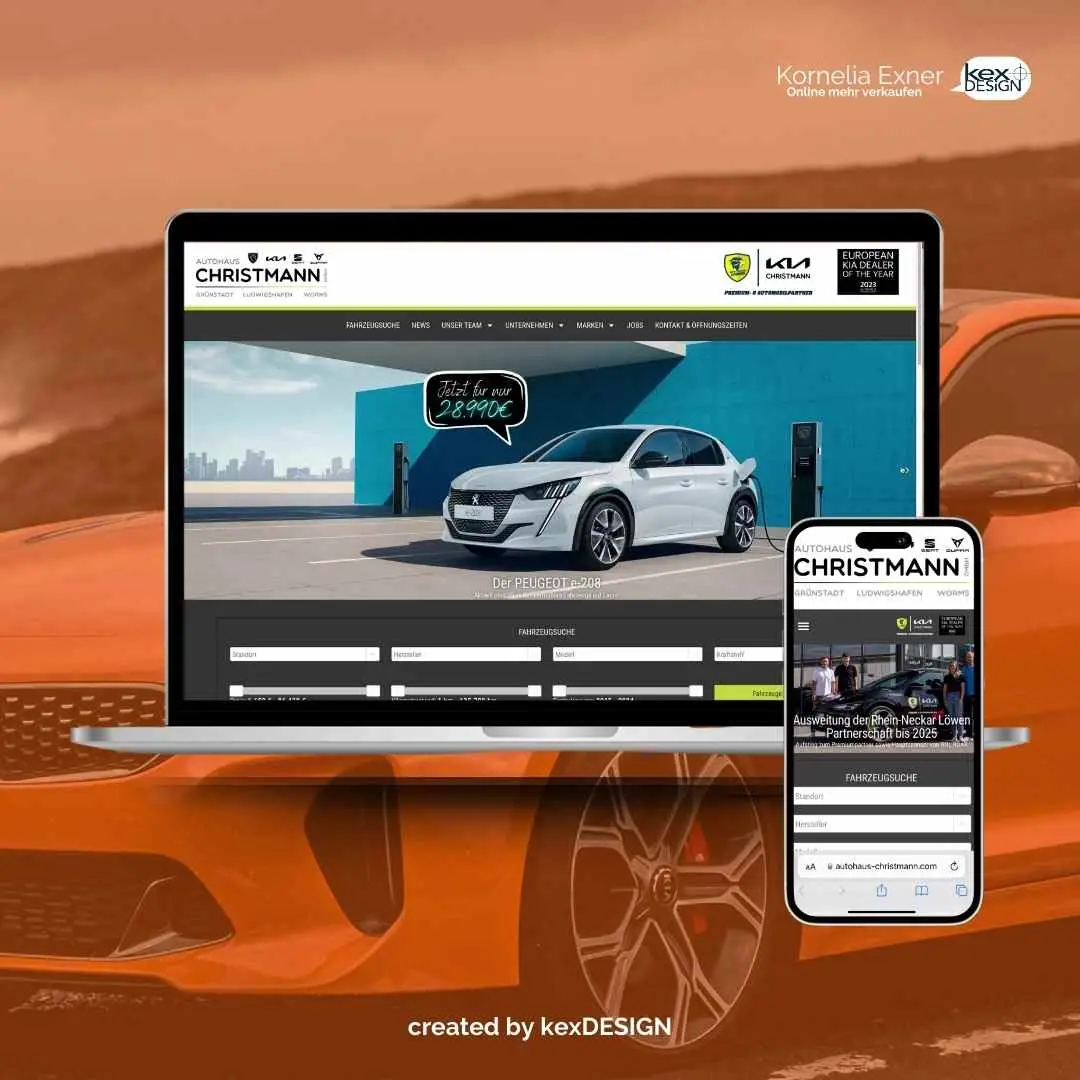

Die „kexDESIGN-Methode“ ist eine ganzheitliche und strategische Herangehensweise, bei der Webdesign mit betriebswirtschaftlichem Wissen und Versandhandels-Know-how kombiniert wird, um eine flexible und automatisierte Website zu erstellen, die potenzielle Kunden anspricht und mit dem Unternehmen wachsen kann.

Simplify your Website

Das Konzept mit echten Ergebnissen!

Übrigens: Solltest du mit deiner Positionierung feststecken oder nicht genau wissen, wie du am besten anfängst, dann schau in mein Buch.

„Simplify your Website“ ist mein Konzept für eine einfache und nachhaltige Umsetzung. Mit dieser Methode kommst du zur Positionierung und authentischen Website-Inhalten, die dich wirklich weiterbringen.